Fernando Massoglia-Jara*a, Cristhian Pérez-Villalobos**b, Juan Arellano-Vega**c, Olga Matus-Betancourt**d

RESUMEN

Introducción: La implementación de sistemas de respuesta en aula es una herramienta útil para mejorar los procesos de enseñanza-aprendizaje. Sin embargo, solo existe un instrumento validado para evaluar la percepción de los estudiantes de uso de los sistemas de respuesta.

Objetivos: Validar la traducción del cuestionario “Evaluación de la Percepción de los Estudiantes sobre los Sistemas de Respuesta en Aula” (CRiSP por sus siglas en inglés) al español.

Material y Método: Se utilizó un diseño no experimental de alcance correlacional. Se realizó una traducción, retrotraducción y evaluación de pares del cuestionario CRiSP. Se encuestó a 217 estudiantes de carreras biomédicas de la Universidad de Concepción. Para el análisis de los datos se utilizó SPSS para realizar el análisis factorial exploratorio y alfa de Cronbach para cada dimensión.

Resultados: Se identificaron tres dimensiones: “Impacto en el aprendizaje”, “Impacto en el engagement” y “Usabilidad”. Sus confiabilidades fueron 0,927; 0,904 y 0,652.

Conclusiones: CRiSP en su versión es español posee consistencia en sus tres dimensiones. Por lo tanto, la evidencia de este estudio sugiere que el uso de CRiSP es un instrumento confiable y válido.

Palabras clave: Educación Médica, Odontología, Estudiantes.

SUMMARY

Psychometric validation of the Scale for the Evaluation of Students’ Perception of Classroom Response Systems.

Introduction: The implementation of classroom response systems is a useful tool to improve the teaching and learning processes. However, there is only one validated instrument to assess students’ perceptions on the use of response systems.

Objectives: To validate the translation of the questionnaire «Evaluation of Students’ Perception of Classroom Response Systems» (CRiSP) into Spanish.

Material and Method: A non-experimental design with correlational scope was used. A translation, retro-translation and peer review of the CRiSP questionnaire was performed. A survey was conducted with 217 students of biomedical careers at the University of Concepción. For data analysis, SPSS was used to perform exploratory factor analysis and Cronbach’s alpha for each dimension.

Results: Three dimensions were identified: «Impact on learning», «Impact on engagement» and «Usability». Their reliability was 0.927; 0.904 and 0.652.

Conclusions: CRiSP in its Spanish version has consistency in its three dimensions. Therefore, the evidence from this study suggests that the use of CRiSP is a reliable and valid instrument.

Keywords: Medical Education, Dentistry, Students.

INTRODUCCIÓN

La educación médica se ha enfrentado a la necesidad de realizar constantes modificaciones ante los permanentes cambios de la sociedad –desde el reporte Flexner1 de 1910 que estableció el modelo biomédico como el estándar de la formación médica, hasta guías más recientes como “Milestone Guidebook” del Accreditation Council for Graduate Medical Education2 del año 2016– que recalcan la importancia de generar un currículo basado en competencias para la formación de profesionales médicos.

Estamos frente a una nueva generación que tiene grandes diferencias con sus predecesoras. Los estudiantes de hoy están insertos en un sistema educacional que no fue diseñado para su generación.

Los sistemas de respuesta en aula, más conocidos como tecleras, son definidos como el uso de tecnología de comunicación que permite a los instructores recopilar y analizar rápidamente las respuestas de los alumnos a las preguntas planteadas en clases3.

Las tecleras han sido incorporadas como una herramienta para mejorar la participación de los estudiantes en forma activa dentro de la sala de clases4. Sus orígenes se remontan a la década de 1960, momento desde el cual han ido evolucionando en cuanto a su forma física, capacidades y disponibilidad. Inicialmente, eran dispositivos similares a un control remoto de televisor cuyas señales eran captadas por un receptor que procesaba la información. El uso del sistema de esta configuración trae consigo la dificultad en iniciar las actividades, ya que requiere de un proceso de entrega y retiro de las tecleras, así como una puesta en marcha de todo el hardware necesario y posee varias limitaciones, como es la incapacidad de relacionar las respuestas específicas con un alumno en particular, el no permitir que el control remoto posea alguna pantalla capaz de entregar información adicional, y la imposibilidad de realizar preguntas más allá de las alternativas5.

La evaluación del aprendizaje6 utilizando evaluaciones formativas continuas con el uso de tecleras genera un aumento en la retención de la información, la estimulación del proceso de aprendizaje y retención del conocimiento de forma directa e indirecta. El efecto directo está dado por el acto de recordar información desde la memoria. El efecto indirecto se genera por una amplia gama de otros métodos en el cual se puede influenciar el proceso de aprendizaje, como es el estudio constante a causa de las frecuentes evaluaciones, a diferencia de cuando solo existe una evaluación final, donde el estudiante generalmente no realiza un estudio constante de los contenidos. Diversos estudios evidencian que el realizar múltiples evaluaciones a lo largo del proceso de aprendizaje logra un mejor resultado en comparación a una evaluación única7.

Existen estudios que han investigado si existe una mejoría en las evaluaciones con el uso de tecleras, encontrándose en general un incremento en la obtención de los resultados de aprendizajes esperados8; por ejemplo, Shapiro9 encontró 20% de diferencia en los resultados de las evaluaciones de temas abordados con el uso de tecleras. Existen dificultades al investigar el uso de tecleras en clases, ya que se introducen variables no controladas como son que en una clase un estudiante realice preguntas con mayor profundidad que en otra, que por imprevistos externos se debe acortar el programa de la asignatura en una clase o que el mismo docente cambie de una clase a otra y sea más efectivo en su exposición10. Por ello, Lantz8 realizó una experiencia en un laboratorio para eliminar factores externos que pudieran influenciar el resultado y encontró que el uso de tecleras con retroalimentación inmediata –al finalizar la presentación– mejoró los resultados de la evaluación realizada dos días después, lo cual demuestra que el uso de tecleras como herramienta para realizar una retroalimentación inmediata llevó no solo a una obtención de mayores puntajes en las evaluaciones, sino que también ayudó a rectificar conceptos erróneos sobre los contenidos presentados en clase.

Como alternativa, cada vez existe un mayor uso de dispositivos móviles inteligentes entre los estudiantes universitarios11, por lo que se puede suplantar el uso de tecleras tradicionales por tecleras que sean aplicaciones para teléfonos inteligentes, que solo requieren de un equipo que posea un navegador de internet y una conexión a internet.

Existe un instrumento estandarizado que permite evaluar las percepciones de los estudiantes del uso de tecleras de manera eficiente, efectiva y comprensiva, denominado “escala para la evaluación de la percepción de los estudiantes sobre los sistemas de respuesta en aula” o CRiSP por sus siglas en inglés, el cual fue desarrollado y validado por Richardson12 en inglés, aplicado a estudiantes de universidades australianas.

El objetivo de este estudio fue validar la traducción de CRiSP al español.

MATERIAL Y MÉTODO

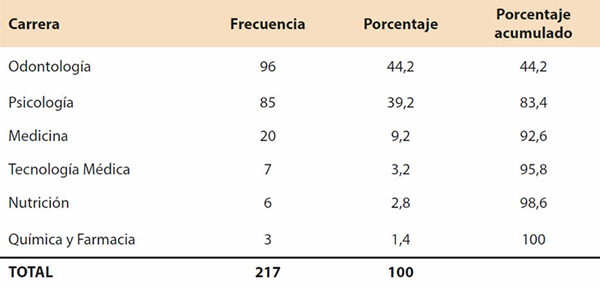

Se utilizó un diseño no experimental de alcance correlacional y una dimensión temporal transversal. Se invitó a participar a 217 estudiantes de carreras de la salud (Tabla 1). Previo a la aplicación del cuestionario, los estudiantes participaron a lo menos en dos clases expositivas en las cuales se utilizó el sistema de tecleras Socrative. Su utilización se dio en tres tiempos diferentes de la clase: antes del inicio de la clase, tanto para evaluar como activar los conocimientos previos relacionados con la clase; en un segundo tiempo durante la presentación, para ir obteniendo retroalimentación sobre los contenidos expuestos; y, finalmente, al término de la clase para realizar una evaluación formativa.

| Tabla 1. Distribución de frecuencias según carreras. |

|

Se aplicó una adaptación al castellano de la versión original del cuestionario para evaluar las percepciones de los sistemas de respuesta en aula (CRiSP). Es un cuestionario que en su versión original consta de 26 preguntas en escala tipo Likert de cinco puntos, las cuales se agrupan en tres dimensiones: impacto en el aprendizaje (12 preguntas), impacto en el engagement (10 preguntas) y usabilidad (4 preguntas). Este instrumento fue validado en inglés por Richardson12 en estudiantes de universidades australianas, obteniendo valores de alfa de Cronbach de .92 para el impacto en el aprendizaje, de .93 para el impacto en el engagement y de .78 para usabilidad.

Para su adaptación se realizó una retrotraducción del instrumento y una evaluación por pares para evaluar su coherencia; luego se aplicó a estudiantes de carreras biomédicas que estuvieran expuestos al uso de tecleras del sistema Socrative.

Se realizó un análisis factorial exploratorio con un método de rotación oblicua (oblimin) utilizando SPSS v21.0.0.0 (SPSS Inc. Chicago, IL, USA) y nivel de significancia <0,05. Esto se debe a que el constructo que contempla el impacto de una tecnología en la participación y aprendizaje no se esperaba que fuese ortogonal, puesto que se asume que los factores tienen correlación entre sí.

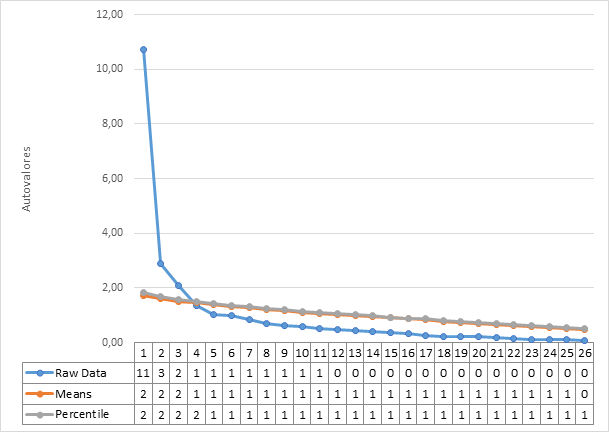

Para el análisis de factores se realizó un análisis paralelo de Horn utilizando la ecuación de O’connor13, lo que implica la generación de correlación de datos aleatorios con el mismo número de variables y participantes para el cálculo del vector propio. Cualquier valor de la base de datos que exceda los valores generados aleatoriamente se considera sustantivo.

RESULTADOS

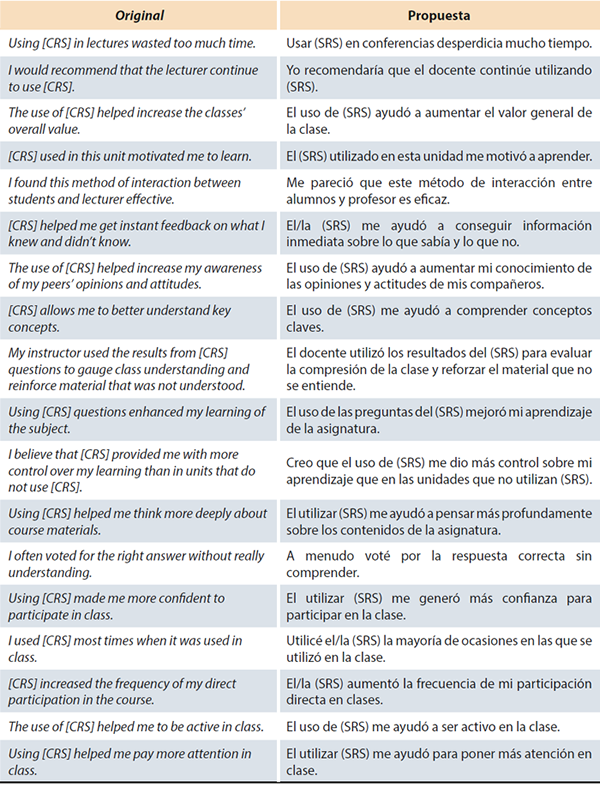

Luego de la traducción y retrotraducción del cuestionario CRiSP, este se evaluó por pares para evaluar la consistencia de constructo de cada ítem (Figura 1).

|

| Figura 1. Cuestionario para evaluar las percepciones de los sistemas de respuesta en aula (CRiSP) en la columna izquierda la versión en inglés y la traducción en la columna derecha. |

Para la validación participaron un total 217 estudiantes con promedio de edad de 21,87 (DS= 3,5) años. Fueron 146 (67,3%) mujeres y 71 (32,7%) hombres, pertenecientes a las carreras de Odontología, Psicología, Tecnología médica, Química y Farmacia, Medicina y Nutrición, distribuidos según la Tabla 1.

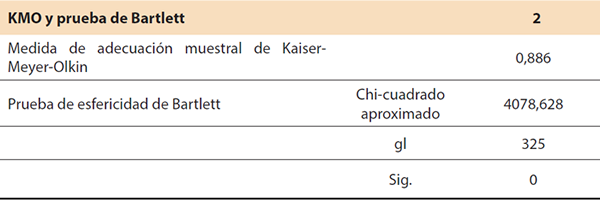

Para su análisis los ítems fueron codificados en forma inversa, de modo que valores altos reflejen resultados favorables en todas las variables. Entre los 27 ítems analizados, el valor de Kaiser-Meyer-Olkin fue de 0,886. Según los lineamientos de Kaiser y Rice14, valores de 0,8 a 0,9 son meritorios, lo cual indica que el análisis factorial es adecuado basado en la estructura de los datos (Tabla 2).

| Tabla 2. Análisis factorial exploratorio utilizando Kaiser-Meyer-Olkin. |

|

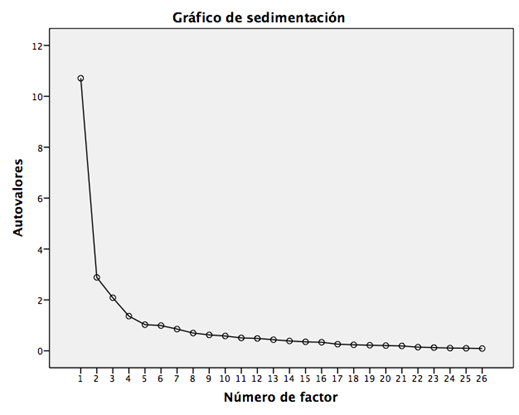

El resultado del análisis factorial exploratorio sugiere el uso de 3 dimensiones, como se observa en la Figura 2.

|

| Figura 2. Análisis paralelo de Horn con uso de permutaciones. |

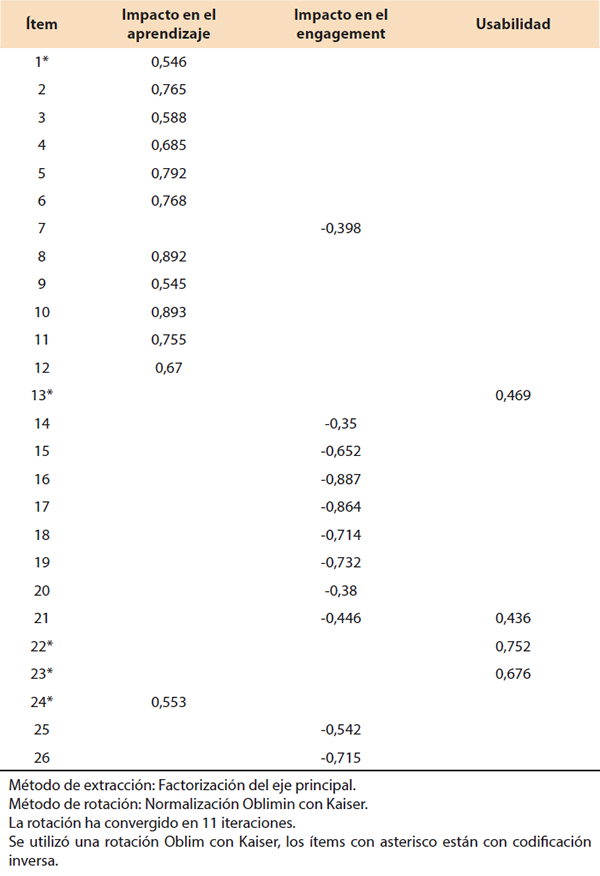

Un modelo de solo una dimensión asume que CRiSP es un constructo unidimensional que se enfoca en la satisfacción en el uso de tecleras, pero el análisis paralelo arroja un modelo de tres dimensiones, las cuales consisten en el impacto en el engagement, el impacto en el aprendizaje y la usabilidad. El análisis factorial utilizando 217 observaciones produce los resultados de la Tabla 3 y Figura 3, con cut-off de 0,3; la extracción se realizó en 3 dimensiones en concordancia con los resultados del análisis paralelo y las dimensiones hipotéticas, los valores del alfa de Cronbach sugieren que las 3 dimensiones poseen una alta confiabilidad (Tabla 3). La matriz de configuración con tres factores se realizó utilizando un método de rotación oblicua (oblimin). Se utilizó una rotación Oblim con Kaiser. Todos los valores que exceden 0,3 están listados15, y no quedó ningún ítem sin ser integrado a alguno de los tres factores.

| Tabla 3. Matriz de Configuración. |

|

|

| Figura 3. Gráfico de sedimentación del análisis factorial exploratorio de CRiSP. |

Para evaluar la consistencia interna de los factores se calculó el coeficiente de confiabilidad alfa de Cronbach de estos. La dimensión de “Impacto en el aprendizaje” presentó un valor de alfa de 0,927; la dimensión “Impacto en el engagement” presentó un valor de alfa de 0,904; y la dimensión “Usabilidad” un alfa de 0.652.

DISCUSIÓN

El resultado del análisis exploratorio factorial que fue aplicado a CRiSP, al igual que en el análisis del instrumento en su idioma original, sugirió que se agruparan en tres dimensiones que definen conceptos similares a los originales, por lo que se utilizaron los mismos nombres para las dimensiones.

Al realizar la traducción no fue posible encontrar una palabra en español que lograra definir el concepto de la lengua inglesa de “engagement”. La traducción literal corresponde a “compromiso”, pero su uso en la literatura educacional inglesa incluye el grado de atención, curiosidad, interés, optimismo y pasión que los estudiantes manifiestan hacia el proceso de aprendizaje; y ya que el concepto de engagement es bastante comprendido por la comunidad hispanoparlante, se tomó la decisión de mantener la palabra en su idioma original.

Frente al análisis de la distribución de los ítems en cada dimensión, encontramos diferencia con el estudio original de Richardson y cols.12 (en general la distribución es similar), encontrándose ítems que poseen una mayor correlación a otra dimensión solo en 5 de los 26 ítems del instrumento. Entre los ítems que demostraron cargar a dimensiones diferentes se encuentran los siguientes:

- “El uso de Socrative ayudó a aumentar mi conocimiento de las opiniones y actitudes de mis compañeros”: en el estudio original este ítem está atribuido a la dimensión “Impacto en el aprendizaje” y en nuestro estudio se atribuye a la dimensión “Impacto en el engagement”.

- “A menudo voté por la respuesta correcta sin comprender”: en el estudio original está asignado a la dimensión “Impacto en el aprendizaje”, y en nuestro estudio se asignó a la dimensión “Usabilidad”. Frente al análisis de constructo del ítem, se definió –a diferencia de la investigación original– que para una correcta interpretación se debía realizar una codificación inversa, debido a que la pregunta es de respuesta negativa.

- “El utilizar Socrative me generó más confianza para participar en la clase”: en el instrumento original estaba asignado a la dimensión “Impacto en el engagement”, y en el estudio se asignó a “Impacto en el aprendizaje”.

- “Para mí fue fácil usar Socrative”: en el estudio original este ítem fue asignado a dos dimensiones “Impacto en el engagement” y “Usabilidad”, lo que metodológicamente no es lo más adecuado. En nuestro estudio también demostró correlación con ambas dimensiones (-0,446 y 0,436 respectivamente), pero al analizar la pregunta en su constructo corresponde a la dimensión “Usabilidad”, por lo que se asignó a esta.

- “Había demasiados problemas tecnológicos utilizando Socrative”: en el estudio original este ítem correlaciona con la dimensión de “Usabilidad” y en nuestro estudio demostró correlación en “Impacto en el aprendizaje”.

CONCLUSIONES

Así, se puede concluir que nuestro estudio cumple con los criterios reconocidos para la validación de instrumentos. CRiSP en su versión en español posee consistencia en sus tres dimensiones. Por lo tanto, la evidencia de este estudio sugiere que el uso de CRiSP es un instrumento confiable y válido.

REFERENCIAS BIBLIOGRÁFICAS

- Duffy T. The Flexner Report ― 100 Years Later. Yale J Biol Med. 2011; 84(3): 269-276.

- Holmboe E, Edgar L, Hamstra S. The Milestones Guidebook. Chicago, IL: Accreditation Council for Graduate Medical Education; 2016.

- Bruff D. Teaching with Classroom Response Systems: Creating Active Learning Environments. San Francisco, CA: John Wiley & Sons; 2009. 240 p.

- Fies C, Marshall J. Classroom response systems: A review of the literature. J Sci Educ Technol. 2006; 15: 101-109.

- Hunsu N, Adesope O, Bayly D. A meta-analysis of the effects of audience response systems (clicker-based technologies) on cognition and affect. Comput Educ. 2016; 94: 102-119.

- Larsen D, Butler A, Roediger III H. Test-enhanced learning in medical education. Med Educ. 2008; 42(10): 959-966.

- Roediger III H, Karpicke J. Test-Enhanced Learning: Taking memory tests improves long-term retention. Psychol Sci. 2006; 17(3): 249-255.

- Lantz M, Stawiski A. Effectiveness of clickers: Effect of feedback and the timing of questions on learning. Comput Human Behav. 2014; 31: 280-286.

- Shapiro A. An empirical study of personal response technology for improving attendance and learning in a large class. J Scholarsh Teach Learn. 2009; 9(1): 13-26.

- Skinner N. University grades and time of day of instruction. Bull Psychon Soc. 1985; 23(1): 67.

- Telefonica. Telefonica Global Millennial Survey: Global Results. 2013; 56.

- Richardson A, Dunn P, McDonald C, Oprescu F. CRiSP: An Instrument for Assessing Student Perceptions of Classroom Response Systems. J Sci Educ Technol. 2015; 24: 432-447.

- Schreiber J, Nora A, Stage F, Barlow E, King J. Reporting structural equation modeling and confirmatory factor analysis results: A review. J Educ Res. 2006; 99(6): 323-338.

- Kaiser H, Rice J. Little Jiffy, Mark IV. Educ Psychol Meas. 1974; 34(1): 111-117.

- Costello A, Osborne J. Best practices in exploratory factor analysis: four recommendations for getting the most from your analysis. Pan-Pac Manag Rev. 2009; 12(2): 131-146.

Artículo recibido el 07/01/19, Aceptado el 17/06/19.

Dirección del autor:

Fernando Massoglia-Jara.

Departamento de Odontología Restauradora,

Facultad de Odontología,

Universidad de Concepción.

Roosevelt 1550, Casilla 160-C

Concepción, Chile.

E-mail: fmassogl@udec.cl

* Departamento de Odontología Restauradora, Facultad de Odontología, Universidad de Concepción, Concepción,

Chile.

** Departamento de Educación Médica, Facultad de Medicina, Universidad de Concepción, Concepción, Chile.

a. Cirujano Dentista, Especialista en Rehabilitación Oral mención Prótesis, Magíster en Educación Médica para las

Ciencias de la Salud.

b. Psicólogo, Doctor en Ciencias de la Educación.

c. Psicólogo, Magíster en Bioestadística.

d. Ingeniero Informático, Magíster en Educación Médica para las Ciencias de la Salud.